ceo扎克伯格:meta将发力语音翻译和语音助手( 三 )

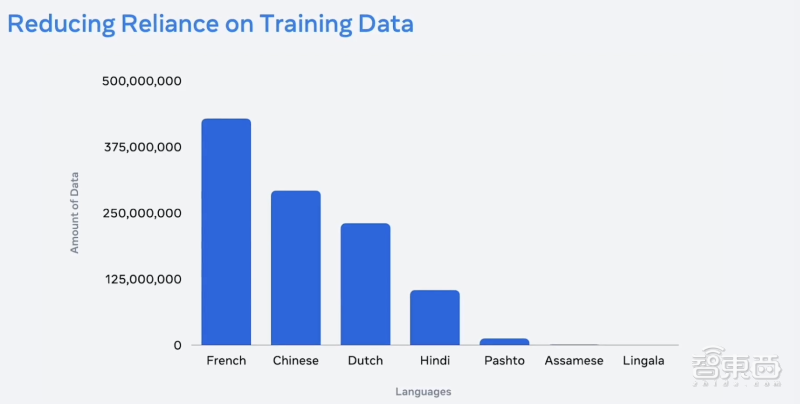

据预测 , 全球大约有20亿人说的母语没有任何可用的翻译系统 。并且 , 全球有数千种语言 , 但翻译系统如今只支持大约100种语言 。

如何创建真正适合每个人的翻译系统是Meta一直在思考的问题 。

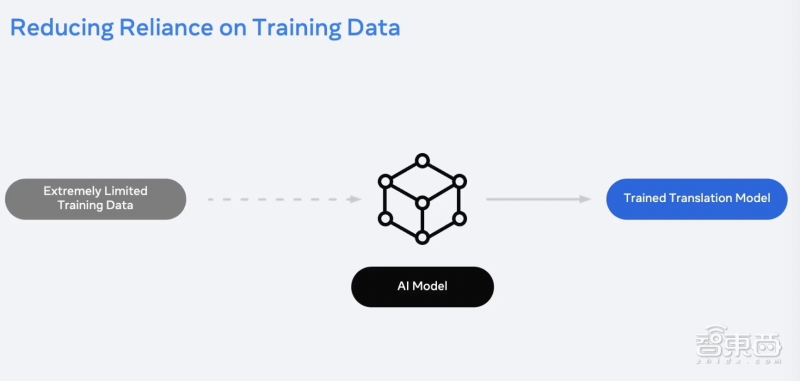

AngelaFan认为 , 创建更具包容性的翻译的第一步是开发能够支持多种语言的系统 。“我们要是想要实现多语种翻译 , 我们就需要必须为每一个语言方向创建一个单独的模型 , 这样一来 , 我们就要创建数万个模型 , 这是一件非常复杂的事情 。”

为了解决这一难题 , Meta尝试根据不同的语言体系来加强模型的训练能力 。比如说 , 罗曼什语作为一个小众语种 , 会与其他语言体系有共同点 , 语种之间的联系将会简化语言模型的开发过程 。

文章图片

文章图片

“最近 , 我们在两个顶级翻译比赛中获胜 。”她讲到 , “我们证明了多语种系统确实比双语系统更好 , 通过增加模型大小 , 例如通过生成更多培训数据和缩小翻译规模 , 我们证明了多语种翻译是一个非常有前途的发展方向 。”

文章图片

文章图片

除此之外 , Meta还可以自动创建一些翻译数据的示例 , 而无须雇用人员手动翻译大量数据 。目前 , Meta已经支持一百多种语言实现自动创建数据集 , 并且部分数据集开源 。

四、Meta计划打造超级语音助手 , 连续决策成AI交互关键

MetaAI的高级研究经理AlborzGeramifard谈到语音交互助手可以分为三个类别 。

第一类是初级的语音助手 。比如说我们想要查询话费 , 打电话给客户服务 , 你会听到请按1键获得话费信息 , 请按2键获得订阅服务等 。“你常常会发现你想要的服务不在选项列表中” 。

第二类语音交互助手 , 但拥有可能有一些智能模型 。“你可能会在家里和它们简单的互动 。但它们不能理解语义背景 , 也不能进行深度交流 。”

第三类是Meta想要打造的超级语音助手 。这类超级语音助手延续了深层次的语境 , 可以为用户提供个性化体验 。比如你想早晨放一首歌曲 , 同时窗外又在下雨 , 超级语音助手就会根据此刻的场景为你推荐一首歌曲播放 。

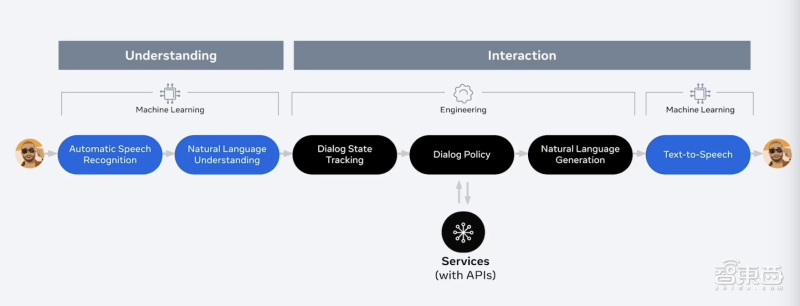

他还谈到 , 能理解的AI和能交互的AI是两种不同的概念 。能理解的AI是一个单向的过程 , 从输入到输出 , 比如说转录音频解析可以得到相应的文本 。

文章图片

文章图片

理解式AI和实时交互AI的区别

而交互是用户和AI之间能实现连续对话 。例如 , 詹姆斯可能想向尼克发送一条消息 , 说他将迟到五分钟 。当AI完成相关操作时 , 詹姆斯想将时间修改到10分钟 , 在这种情况下 , 詹姆斯可以继续修改他的时间安排 , AI也能完成相关操作 。在交互式的对话中往往会涉及连续决策的问题 。

文章图片

文章图片

“我们的目标是将我们的项目打造的新模型与VR/AR设备相结合 , 通过AI实现更具沉浸式和多模态的交互形式 。”

比如说 , 你的语音助手可以帮助你制作美味的食材 , 根据你的食谱列出食材 , 并主动引导你完成整个过程菜谱 。并且 , 当你在这道菜中添加了盐时 , 超级语音助手注意到你的盐越来越少了 , 所以帮助你下了一个购物的订单 。超级语音助手与你之间的互动越来越紧密 。

- facebook创始人扎克伯格要转型做元宇宙

- 易车CEO张序安:易车将通过升级数字能力,从内、外部为经销商带来增量

- 扎克伯格的“元宇宙计划”崩盘壮举

- 星巴克悄悄涨价,涉及多款产品!CEO称预计未来几个月还将提价

- 世界最高密度商业化电池单元,特斯拉ceo马斯克偏保守了些

- 暖流科技获数千万元A轮融资 CEO刘兰斌:供热行业向人工智能控制阶段进阶是必然趋势

- amdceo苏姿丰当选amd董事长总裁、董事长

- 每迈一步都受到密切关注:Facebook转型元宇宙比扎克伯格创业难多了

- arm新任ceo:单打独斗不妨碍未来计划

- 金铲铲之战炼金格斗扎克娱乐阵容怎么选(金铲铲之战炼金格斗扎克娱乐阵容配队方案介绍)