看四家技术代表如何演绎智能驾驶的“百家争鸣”!( 二 )

文章图片

文章图片

基于这个思路 , 特斯拉是如何演进的呢?特斯拉必须依赖神经网络算法来解决来自摄像头的所有数据 , 首先我们看看特斯拉视觉路线最为复杂的神经网络 。1、确认视觉路线: 从单相机走向多相机融合(1) 单相机方案起初 HW1 主要围绕了 Mobileye EyeQ3 以及一颗英伟达 Tegra 3 , 采用了单相机方案 , 也就是一颗前置摄像头、一颗前置毫米波雷达以及 12 个超声波雷达 。单相机的方案其实和目前我们看到的 ACC+LCC 这样的基础功能相类似 。所以在 Andrej Karpathy 加入之前 , 特斯拉在 AI 技术并不惊艳 。通过利用单摄像头、单帧对多任务模型处理 , 例如图像识别、跟踪、语义分割等 , 神经网络也并不复杂 。

文章图片

文章图片

(1)多相机、单帧方案在 2016 年时特斯拉因为 Mobileye 的低算力、封闭性后与其分道扬镳 , 并且也确定了基于 8 摄像头融合的视觉方案 , 也就开启了 FSD 的演进之路 。而在这过程中特斯拉发现虽然利用 8 个跨相机融合 , 但问题依旧没法解决 。因为这 8 个摄像头其实是「单摄像头」、「单帧」“各自作战” , 无法连续输出:问题一:首先是检测与预测不稳定 。例如一辆车在我们身边经过 , 那么它可能一次性穿越八个摄像头中的其中五个 , 不同角度的摄像头这时候系统该听哪个摄像头的呢?这让系统无法对车辆做好的预测(例如它往哪里走、对我有无影响) 。

文章图片

文章图片

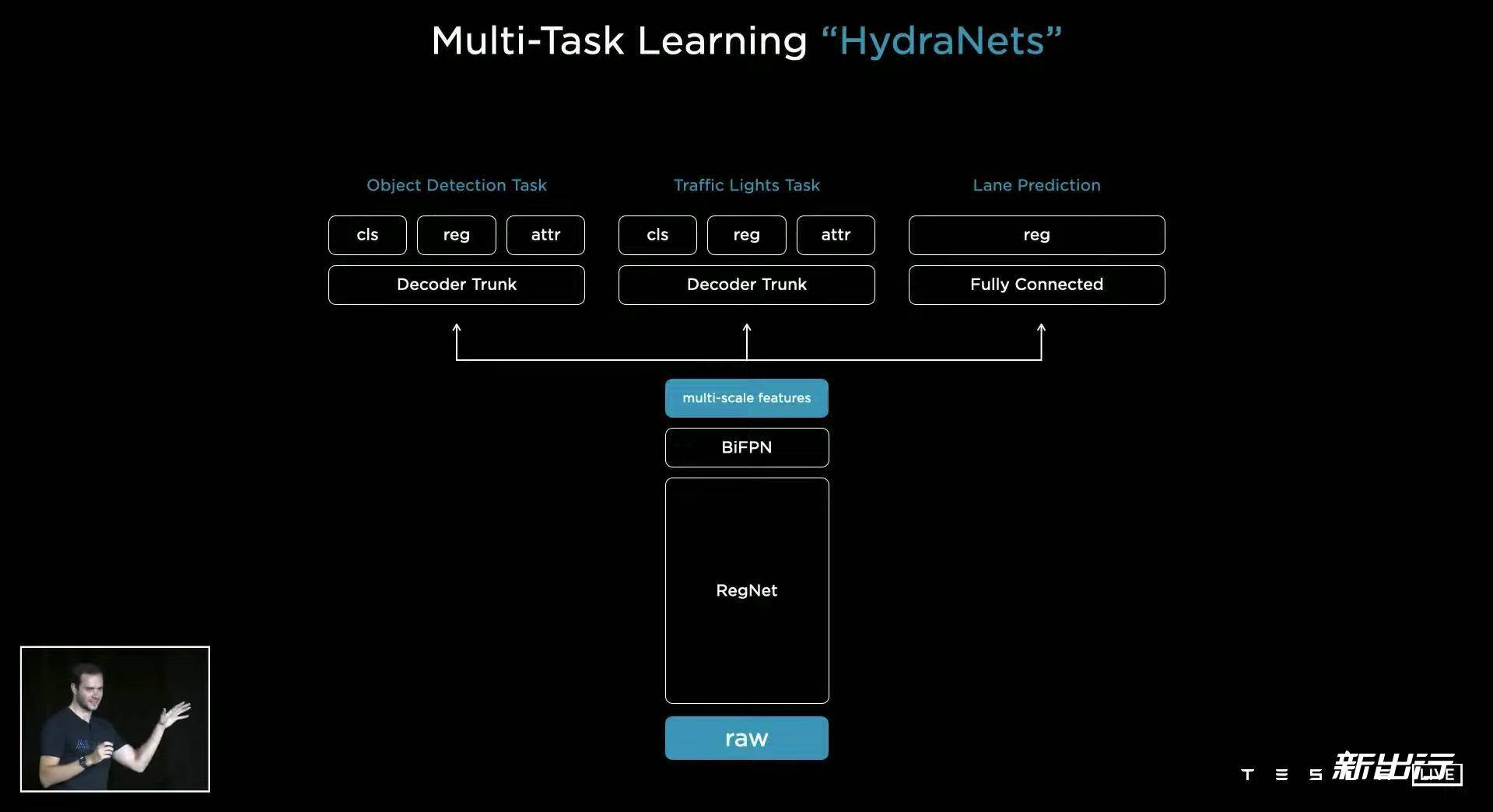

而如果车辆穿过不同摄像头边界时还会出现检测不稳定、卡顿的现象 。问题二:跨相机融合的图像无法输出连续图像跨镜头融合的图像空间实际上跑起来不是一个可用的空间 。单帧的难点就在于我们只知道看到当前的东西是什么 , 但无法生成连续图像 , 也就是无法知道所见物体的「来龙去脉」 。这就有点像泊车时的第一次建模地图 , 它只能渲染出当前附近的环境信息 , 但没有大量高精度信息和深度信息 , 拿来开放道路并不好用 。而这些难题 , 就是特斯拉接下来需要解决的 。(3) 多相机、多帧 方案 ( 当前方案 )在这个阶段特斯拉则做了一个新的解决方式 , 既然 8 个摄像头那么多意见 , 为何要和多个摄像头过不去呢?那倒不如把这么「多摄像头」融合成「一个超级摄像头」 , 然后再统一输入给神经网路 。这就是特斯拉当前神经网络的技术脉络:通过主干来分配任务、再消化多个任务 。解决的方法是先把多个摄像头来的图像信息先融合起来 , 再把它输入给神经网络 , 然后直接输入给具有三维的矢量空间里 。( 特斯拉称其为多任务神经网络 HydraNet ) 。

文章图片

文章图片

那每时每刻这么多数据处理势必存在压力 , 所以在推向给系统前 , 这些图像会首先被“肢解” 。在整个结构中我们看到图像先送往 RegNet , 这个网络就是一个深度学习网络 , 这个网络的任务处理比较有意思:它就像一个金字塔 , 底部是专门对高分辨率信息的提取 , 需要确认图像中有哪些细节点 , 例如哪些是人、哪些是车、车道线等诸类问题 。筛选后在给下一层 , 以此类推直达到顶层就会生成一个低分辨率的图像 , 满是信息点 。最后通过 BiFPN、Transformer 以后就是把这些“超浓缩”的信息更加具体化 , 例如这辆车在哪里、速度是多少、在哪个位置等等然后呈现在 Vevtor Space(3D环境感知) 。

- AI技术创新、模型创新、业务创新 全新服务模式助力金融机构数字化转型

- 年会礼品怎么选?不妨看看讯飞智能录音笔SR702、人体工学椅

- 百度地图升级智能手表导航 可查看公交地铁到站提醒

- 支付宝小程序收藏动态在哪看:具体的使用方法查看

- 克服天然缺陷!人工高效生物固氮技术潜力巨大

- 学历备案表怎么查询打印(学历备案表查看下载步骤一览)

- 怎么看腾讯看点历史记录(腾讯看点历史记录查询步骤详解)

- 抖音拉黑别人怎么不看对方视频(抖音拉黑好友具体步骤)

- 微信加别人的记录怎么查询(微信加别人的记录查看步骤解析)

- 抖音账单能不能删(抖音查看账单方法详解)