揭秘iPhone 13电影效果模式,苹果竟然是这样把它打造出来的( 三 )

文章图片

文章图片

苹果在「电影效果模式」上花了很多时间来试图模拟这位跟焦员的手活 , 因此我们在用「电影效果模式」拍摄 , 在不同焦点切换时 , 并非机械式的快速推拉 , 而是有着较为明显的跟焦过程 。

当然 , 「电影效果模式」也才刚刚发布 , 就如同「人像模式」一般 , 它还有不少可优化的地方 。

这就好像你看到郎朗弹钢琴是如此的轻松写意 , 但你知道不可能用算法做到(只能去不断接近)他这种大师级的水准 。

「电影效果模式」落地背后的功臣 A15

既然是通过算法「猜」出来的 , 那理论上「电影效果模式」可以通过 OTA 下放到其他的 iPhone 之中(比如 iPhone 12) , 只是可能会牺牲实时预览 。但以苹果的思路 , 很难通过牺牲一些体验来把新功能下放 。

文章图片

文章图片

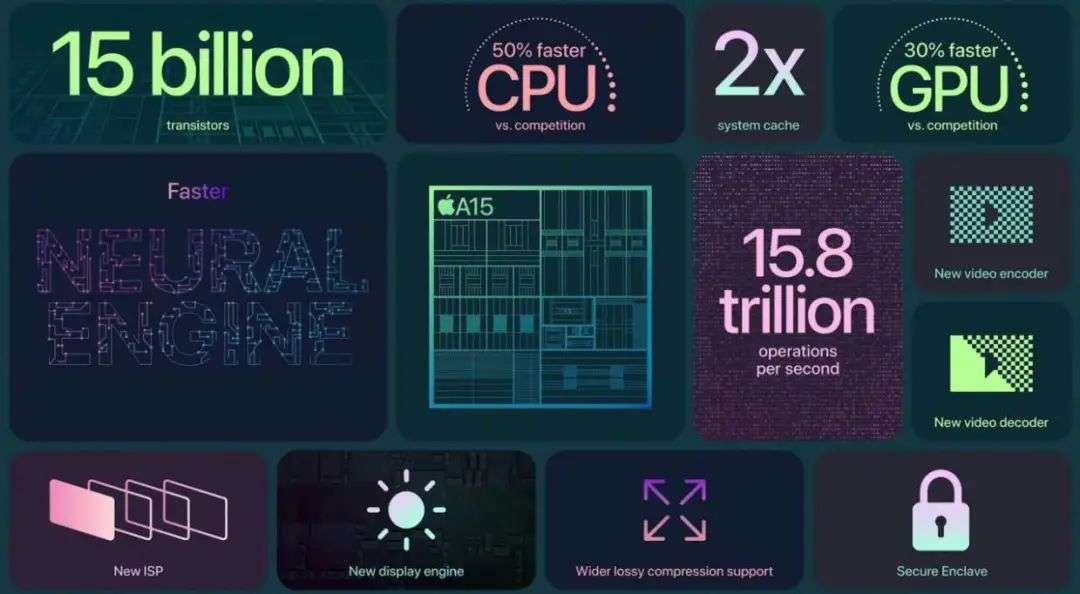

A15 提升要点 , 注意 CPU、GPU 的提升是与竞争对手相比.

因此 , 「电影效果模式」会是 iPhone 13 全系列的一个暂时独享的功能 , 也会是 A 系芯片算力的一个门槛 , 也可能会成就新一代的 iPhone「钉子户」 。

iPhone 营销副总裁凯安(Kaiann Drance)在采访中就表示让视频自带模拟景深比人像照片更具「挑战性」 。

文章图片

文章图片

iPhone 营销副总裁 Kaiann Drance.

视频需要随着被摄者移动而移动 , 需要实时防抖(数码加光学) , 并准确识别不同的场景、人物、动物、物体 , 因此对于神经引擎和机器学习来说 , 需要质量更高的深度数据 , 并且实时的渲染出来 。

哦 , 还有实时对焦 , 以及对杜比视界 HDR 编码的支持 。而这一切的背后都来自于 A15 , 可谓小小的年纪承担了全家的重任 。

文章图片

文章图片

相对于 A15 的 CPU , 在实测之中 , GPU 性能提升明显 , 它或许采用了全新的架构 , 以及多堆了一颗核心 。另外 , A15 的神经网络引擎算力提升到了 15.8TOPS 。

而这些硬件上的改进或许是跟本次 iPhone 13 全系在视频功能上提升不无关系 。「电影效果模式」中包含的一些不同于静态照片的机器学习难题 , 相信在 A15 开发之时 , 约翰所在的人机交互设计团队就已经与芯片开发做过深入交流 。

文章图片

文章图片

在 TechCrunch 的测试视频之中 , 他们还发现了 iPhone 13 系列的「电影效果模式」在识人的过程中 , 会运用冗余的传感器进行主体的预测 。

马修女儿的后脑勺一出现在画面中 , 他手里的 iPhone 13 立刻就把焦点切换好了 , 就好像在舞台剧中 , 有一位全局掌控的导演一般 , 主角未登场 , 提前就备好了灯光 , 并引领观众一同期待她的出现 。

针对「电影模式」的这个细节 , 苹果人机交互设计师约翰说到:

我们在观察电影制作时发现 , 跟焦员并非是等主角登场之后再去移动焦点 , 而是有一个预测过程 。我们也通过冗余传感器 , 来通过机器学习来预测画面外人们的运动 , 当他们出现在画面的时候 , 焦点也已经在他们身上了 。

乔布斯曾很喜欢说 , 苹果是处于技术与艺术的交叉点 。

- 今年的iphonese,还是你熟悉的模样

- 「星辰大海」37层楼高、能“钻”到地球最深点……建造者揭秘“蓝鲸1号”到底有多强?

- 苹果iphonese或提前到2023年发布

- 1吨月壤约有12克水,揭秘月球本地水来源,嫦娥五号或带来新证据

- 苹果新机或冠之以“iphonese+5g”名字

- 来法华镇路这里,为你揭秘“上天入海”那些事儿……

- 苹果计划2023年发布第四代iphonese

- 关于iphone14系列的爆料,这样的苹果你还喜欢吗?

- 小屏旗舰iphone13mini销量不理想

- 苹果悄悄开启iphonexsmax国行版ios14.1