培育强人工智能的「ImageNet」:上海交大卢策吾组提出铰接物体知识库 AKB-48( 二 )

(1)用于类别级铰接物体姿态估计的「姿态模块」:该模块旨在估计某类中未曾见过的铰接物体的每个部位的 6D 姿态 。然而 , 以往的研究通常针对于运动类别 , 定义某个类别的物体具有相同的运动结构 。我们的姿态模块将「类别」的概念扩展到「语义类别」 , 同一类物体可以具有不同的运动结构 。

(2)用于铰接物体重建的「形状模块」:获得姿态后 , 我们再对输入图像进行形状编码 , 重建每个部位的形状 。完整的几何信息对于决定在哪里进行交互控制至关重要 。

(3)用于铰接物体控制的「控制模块」:通过感知获得铰接信息(例如 , 部位分割、各部位姿态、铰接属性、完整网格)后 , 就可以根据观察结果推断出交互策略 。我们设置了「打开」和「拉动」的操作任务 , 分别对应于转动铰接和移动铰接 。

针对每个模块评估时 , 我们假设模块的输入是上一个模块的 Ground Truth 。针对整个系统评估时 , 输入是上一个模块的输出 。显然 , 我们不能对 AKB-48 支持的所有任务进行基准测试 。我们希望它能成为未来计算机视觉和机器人领域中的铰接研究的良好平台 。

本文的贡献包括以下三点:

(1)提出了 AKB-48 数据集 , 它包含 48 个类别的 2,037 个铰接模型 , 我们采用了一个多模态知识图 ArtiKG 来组织丰富的标注信息 。该数据集有助于缩小当前的视觉和具身人工智能研究之间的差距 。据我们所知 , 这是第一个从现实世界收集到的具有丰富标准信息的大规模铰接数据集 。

(2)提出了一种快速铰接知识物体建模流程 FArM , 使得从现实世界中收集铰接物体信息更加容易 。在构建真实世界的三维模型数据集时 , 该流程可以大大降低时间和金钱成本阿 。

(3)提出了一种用于整体类别级视觉铰接操作(C-VAM)任务的新型架构 AKBNet 。实验表明 , 该架构的各个部件和整体模型在现实世界中是有效的 。

2

铰接知识库:AKB-48

在构建知识库时 , 我们需要回答三个问题:(1)我们应该标注物体的什么类型的知识?(2)我们应该标注什么物体 , 物体来自真实世界还是模拟世界?(3)如何高效地标注物体知识?

铰接式物体知识图谱 ArtiKG

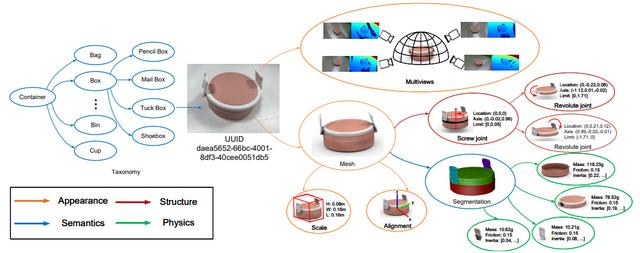

不同的任务需要不同种类的物体知识 , 为了统一标注的表征 , 我们将其组织成一个多模态知识图谱 ArtiKG 。ArtiKG 由四个主要部分组成 , 即外观、结构、物理属性和语义 。

文章图片

文章图片

图注:AKB-48 数据集中定义的铰接只是图谱(ArtiKG) 。

外观

我们将每个实例的形状与网格数据结构以及纹理存储在一起 。从现实世界中扫描对象时 , 我们也会收集对象的多视图 RGB-D 快照 。

结构

铰接物体和刚体物体的关键区别在于运动结构 。被铰接的物体有关节和部位这样的概念 , 这些概念对于刚体来说是没有意义的 。对于每个关节 , 我们标注了关节的类型、参数和运动限制 。对于每个部位 , 我们将每个运动部位分割出来 。

语义

在对基本的几何和结构信息进行标注之后 , 我们以从粗到细的过程为物体赋予语义信息 。我们为每个实例赋予了一个 uuid 。接着 , 我们根据 WordNet 为物体分配类别 。此外 , 我们还标记了部位的语义 。虽然我们已经标注了运动学上的部位 , 但它与语义部位并不完全相同 。以带把手的马克杯为例 , 把手并不是通过关节附着在马克杯本体上 , 因此它不是一个运动学上的部位 , 而是一个语义上的部位 , 因为它表明了人类通常抓取马克杯的位置 。

- 苹果准备最强ipadpro将搭载m2处理器

- 为什么iPhone还是最强录像手机?实测对比给你答案

- iphone13promax全面改造成功,华强北师傅亲自改造

- 魔兽世界9.2最强职业推荐(9.2新手玩家适合的职业分享)

- “芯”能再进一步 realme Book增强版轻薄本强在哪?

- 技嘉发布史上最强迷你机:0.8升好身材 貌似啥也不缺了

- 英国出台开车玩手机最强禁令!8千元扣6分够狠

- 元宇宙新鲜事广州天河宣布入局“元宇宙” 北、上、深为全国元宇宙企业分布前三强

- 全球独角兽esta新增一家人工智能公司——cresta

- 为防疫加把“科技锁”!强生62580平台上线新功能,助力疫情防控更精准高效