用AI打破编解码器内卷,高通最新几篇顶会论文脑洞有点大( 二 )

文章图片

文章图片

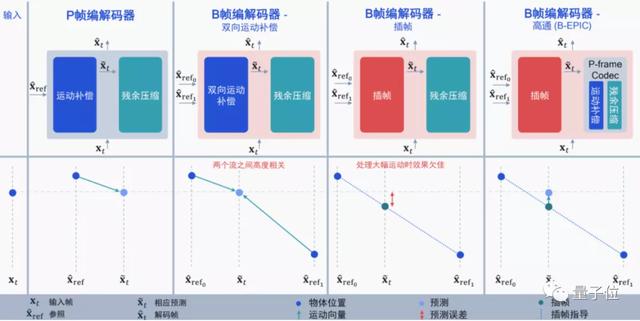

目前的编解码大多集中在I帧(帧内预测)和P帧上 , 而B帧则是同时利用I帧和P帧的双向运动补偿来提升压缩的性能 , 在H.265中正式支持(H.264没有) 。

虽然用上B帧后 , 视频压缩性能更好 , 但还是有两个问题:

一个是视频需要提前加载(必须提前编码后面的P帧 , 才能得到B帧);另一个是仍然会存在冗余 , 如果I帧和P帧高度相关 , 那么再用双向运动补偿就显得很浪费 。

打个比方 , 如果从I帧→B帧→P帧 , 视频中只有一个球直线运动了一段距离 , 那么再用双向运动补偿的话 , 就会很浪费:

文章图片

文章图片

这种情况下 , 用插帧似乎更好 , 直接通过时间戳就能预测出物体运动的状态 , 编码计算量也更低 。

但这又会出现新的问题:如果I帧和P帧之间有个非常大的突变 , 例如球突然在B帧弹起来了 , 这时候用插帧的效果就很差了(相当于直接忽略了B帧的弹跳) 。

因此 , 高通选择将两者结合起来 , 将基于神经网络的P帧压缩和插帧补偿结合起来 , 利用AI预测插帧后需要进行的运动补偿:

文章图片

文章图片

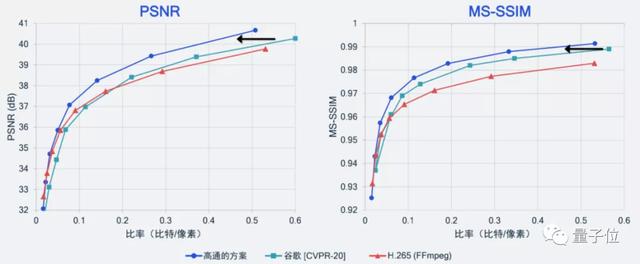

别说 , 效果还确实不错 , 比谷歌之前在CVPR 2020上保持的SOTA纪录更好 , 也要好于当前基于H.265标准实现开源编解码器的压缩性能 。

文章图片

文章图片

除此之外 , 高通也尝试了一些其他的AI算法 。

用“过拟合”降低解码复杂度

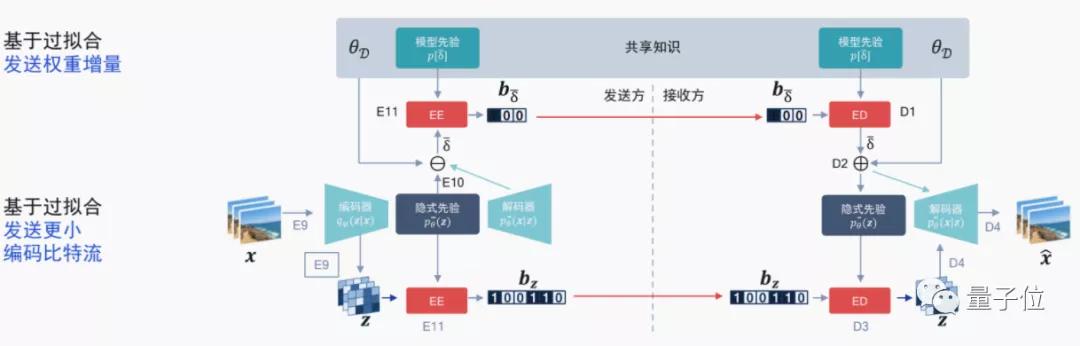

针对编解码器标准内卷的情况 , 高通也想到了用AI做自适应算法 , 来像“过拟合”一样根据视频比特流更新一个模型的权重增量 , 已经有相关论文登上ICLR 2021 。

文章图片

文章图片

这种方法意味着针对单个模型进行“过拟合” , 对比特流中的权重增量进行编码 , 再与原来的比特流进行一个比较 。如果效果更好的话 , 就采用这种传输方式 。

文章图片

文章图片

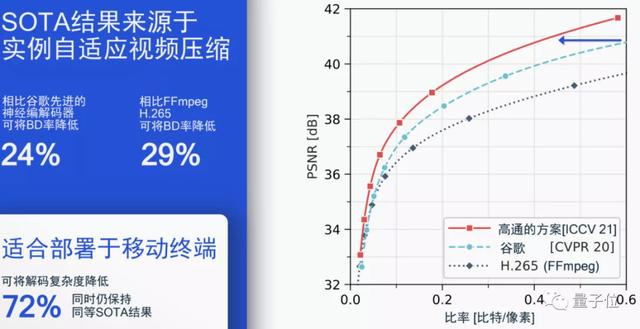

事实证明 , 在不降低压缩性能的情况下 , 这种方法能将解码复杂度降低72% , 同时仍然保持之前B帧模型达到的SOTA结果 。

当然 , 除了视频压缩性能以外 , 单帧图像被压缩的质量也需要考虑 , 毕竟视觉效果也是视频压缩追求的标准之一 。

用语义感知和GAN提高压缩质量

用语义感知和GAN的思路就比较简单了 。

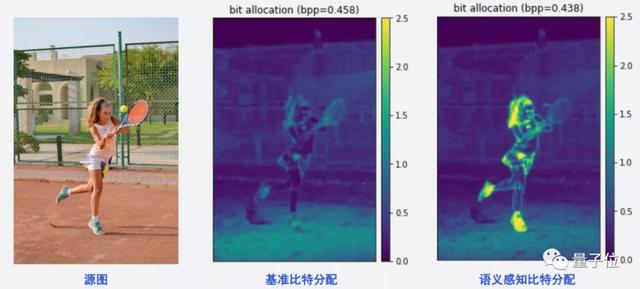

语义感知就是让AI基于人的视觉来考虑 , 选出你在看视频时最关注的地方 , 并着重那部分的比特分配情况 。

例如你在看网球比赛时 , 往往并不会关注比赛旁边的观众长什么样、风景如何 , 而是更关注球员本身的动作、击球方法等 。

那么 , 就训练AI , 将更多的比特放到目标人物身上就行 , 像这样:

文章图片

文章图片

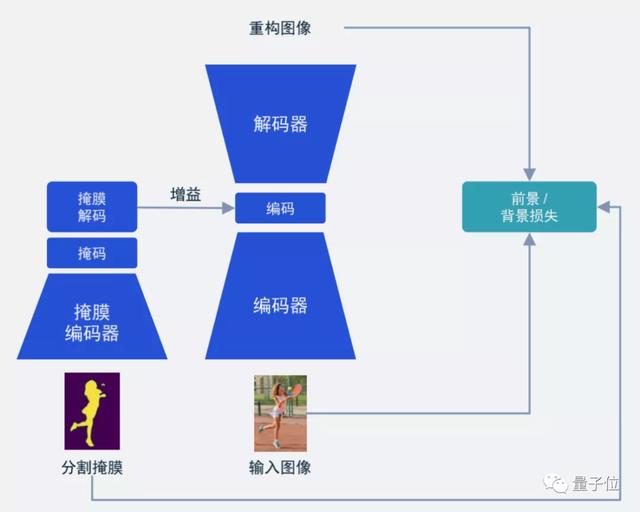

从结构上来讲也比较简单 , 也就是我们常见的语义分割Mask(掩膜):

- “5G+AI”新应用来了!5G秘书帮你轻松搞定接电话、查天气

- 爱立信起诉苹果公司5g专利费用纠纷电信企业再次起诉

- 遍知教育赋能升级或将打破知识付费行业格局

- 复苏的魔女竞技场用什么队伍(复苏的魔女竞技场队伍搭配心得分享)

- 阴阳师百闻牌化身有什么用(阴阳师百闻牌化身机制分析)

- 复苏的魔女时空裂隙用什么阵容好(复苏的魔女时空裂隙阵容搭配指南)

- 原神追忆之注连适合谁来用(原神追忆之注连适合角色分析)

- 复苏的魔女蛇女法队阵容选什么(复苏的魔女蛇女法队好用阵容推荐)

- 伊甸园的骄傲安罗尔好用吗(伊甸园的骄傲安罗尔强度分析)

- 原神绝缘之旗印适合哪些角色(原神充能圣遗物适用角色推荐)