gpt-3是人工智能的一个重要因素

从2020年开始 , 国际最顶尖的AI技术发展 , 愈来愈像一场比拼资金与人才的军备竞赛 。

2020年 , OpenAI发布NLP预训练模型GPT-3 , 光论文就有72页 , 作者多达31人 , 该模型参数1750亿 , 耗资1200万美元;

2021年1月 , 谷歌发布首个万亿级模型SwitchTransformer , 宣布突破了GPT-3参数记录;

4月 , 华为盘古大模型参数规模达到千亿级别 , 定位于中文语言预训练模型;

11月 , 微软和英伟达在烧坏了4480块CPU后 , 完成了5300亿参数的自然语言生成模型(MT-NLG) , 一举拿下单体Transformer语言模型界“最大”和“最强”两个称号;

今年1月 , Meta宣布要与英伟达打造AI超级计算机RSC , RSC每秒运算可达50亿次 , 算力可以排到全球前四的水平 。

除此之外 , 阿里、浪潮、北京智源研究院等 , 均发布了最新产品 , 平均参数过百亿 。

【gpt-3是人工智能的一个重要因素】看起来 , 这些预训练模型的参数规模没有最大 , 只有更大 , 且正以远超摩尔定律的速度增长 。其在对话、语义识别方面的表现 , 一次次刷新人们的认知 。

本文 , 我们试图回答三个问题:

1.AI大模型 , 越大越好吗?

2.大模型的技术瓶颈在哪里?

3.它是实现强人工智能的希望吗?

一、大力出奇迹

人工智能的上一个里程碑出现在2020年 。

这一年 , 由OpenAI公司开发的GPT-3横空出世 , 获得了“互联网原子弹” , “人工智能界的卡丽熙” , “算力吞噬者” , “下岗工人制造机” , “幼年期的天网”等一系列外号 。它的惊艳表现包括但不限于:

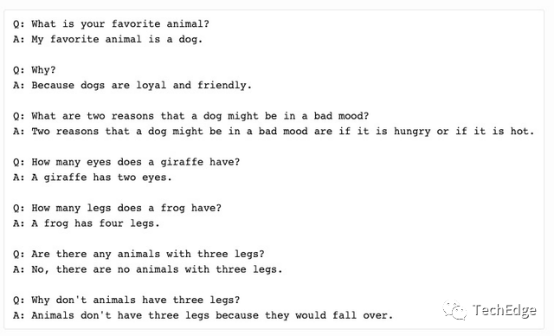

有开发者给GPT-3做了图灵测试 , 发现GPT-3对答如流 , 正常得不像个机器 。“如果在十年前用同样的问题做测试 , 我会认为答题者一定是人 。现在 , 我们不能再以为AI回答不了常识性的问题了 。”

文章图片

文章图片

艺术家和程序员MarioKlingemann , 想让GPT-3写一篇论述“上Twitter重要性”的短文 。他的输入条件是1)题目:“上Twitter的重要性”;2)作者姓名:“JeromeK.Jerome”;3)文章开头的第一个字"It" 。

GPT-3不仅行文流畅 , 更是在字里行间暗讽 , Twitter是一种所有人都在使用的、充斥着人身攻击的社交软件 。

更高级的玩法是 , 开发者在GPT-3上快速开发出了许多应用 , 例如设计软件、会计软件、翻译软件等 。

从诗词剧本 , 到说明书、新闻稿 , 再到开发应用程序 , GPT-3似乎都能胜任 。

为什么相较于以往的AI模型 , GPT-3表现得如此脱俗?答案无他 , “大力出奇迹” 。

1750亿参数、训练成本超过1200万美元、论文长达72页 , 作者多达31人 , 就连使用的计算也是算力排名全球前五的“超级计算机” , 拥有超过285000个CPU , 10000个GPU和每秒400G网络 。

“壕无人性”的结果 , 创造出两个里程碑意义:

首先 , 它本身的存在 , 验证了参数增长、训练数据量增大 , 对AI模型的重要意义 , “炼大模型” , 的确能让AI取得突破性效果;

其次 , 它使用了小样本学习(Few-shotLearning)方法 , 令预训练模型在不必使用大量标记的训练数据 , 并持续微调的情况下 , 仅仅只要给出任务描述 , 并给出几个从输入到输出示例 , 便能自动执行人物 。这意味着 , 它将突破AI碎片化难题 , 让后续开发者得以在巨人肩膀上发展 , 而不用针对一个个场景“平地起高楼” 。

GPT-3之后 , AI大模型军备赛才真正加速打响 。一年之内 , 有头有脸的巨头争相拿出了成绩 , 秀组足肌肉 。国外有谷歌、微软、Meta等巨头 , 国内如华为、阿里、浪潮等企业均下场参战 , 模型平均参数上百亿 。

- 张小龙:小程序不是一个普适性的工具

- 2022摩尔庄园3月3日神奇密码是多少(摩尔庄园手游3.3cdk礼包码分享2022)

- 创造与魔法2022年3月3日兑换码是什么(2022创造与魔法3.3cdk礼包码分享)

- 2022原神礼包码3.3(原神手游3月3日兑换码是多少)

- 王者荣耀桑启技能是什么(王者荣耀新英雄桑启技能一览)

- 剑桥酷炫新发明:卷起来,一块布就是一个显示屏

- 支付宝蚂蚁庄园2022年3月4日答案是什么(羊城是我国哪个城市的别称?3月4日答案解析介绍)

- 支付宝蚂蚁庄园2022年3月4日答案更新(二月二,龙抬头,这里的龙最初指的是?3月4日答案分享)

- 全球主机游戏市场规模已达600亿美元 索尼依然是yyds

- 经济日报谈歇业制度:暂时歇业是为了更好创业你赞同吗?