人工智能的性别化,是利大于弊还是弊大于利?

【人工智能的性别化,是利大于弊还是弊大于利?】“头像是我 , 不满意?”如果男性机器人或AI智能体 , 开始跟你说爹言爹语 , 你是什么感觉?

“你再说我会脸红的哦” , 如果女性机器人或AI智能体 , 用茶言茶语来表达顺服 , 你会开心吗?

不管你相不相信、喜不喜欢 , 人工智能(无论算法软件 , 还是机器人)的性别化 , 以越来越快的速度进入主流消费产品当中 , 频繁出现在你我的生活里 。这时 , 人类社会中既有的性别规范 , 包括性别偏见 , 也被复制到了数字世界当中 。

性别化的常见做法 , 包括通过语音(男声/女声)、姓名、体格以及其他特征 , 赋予智能体一种类似人的性别特征 。比如Siri、Alexa、照护机器人、客服机器人等 , 往往都被默认注入女性气质;而空间站中的AI助理、裁判机器人、导航助手等 , 则特别流行男性气质 。

文章图片

文章图片

人工智能的性别失衡 , 并不是一个距离大家很遥远的话题 。

现在 , 我们身边已经环绕着各种各样的智能体 , 提供从咨询、娱乐、配送、教育、政务、金融、医疗、照护等全方位的服务 。AI如何对待不同性别的人类 , 人类如何与不同性别的AI沟通交流 , 会直接影响我们的生活品质 。

至少目前来看 , 在一个充满性别规范的世界中 , 智能体也难逃陈旧的性别偏见 。比如女性AI就应该柔顺 , 男性机器人就必须强壮 , 男智能客服不如女智能客服温柔亲切……

人类社会的性别观念 , 是如何影响人工智能的?AI的性别化是利大于弊还是弊大于利?既然技术无法降速 , 那么如何让数字世界不再复制性别偏见 , 值得每一个期待明天更好的人——无论男女——开始思考并行动 。

调校AI:像个淑女 , 或者硬汉

众所周知 , AI算法是需要人类来训练的 。那么先来聊聊 , 人类是如何用性别规范来调校AI的 。

女性AI , 要像个完美助手 。

无论是智能语音助手 , 还是智能机器人 , 但凡负责的是服务型、支持型角色 , 往往会被优先设计为女性 。

“她们”往往作为助手 , 大家已经熟悉Siri、Cortana和GoogleAssistant等默认采用女声的语音助理了 , 这里就不再重复 。疫情流行使得服务型机器人开始被酒店、银行等服务业引入 , 而这些负责倒咖啡、打扫房间、处理咨询等的机器人 , 往往都被设计得具有“女性”特征 , 比如更小巧的体型、温暖而充满情感的声音、涂上粉色的嘴唇……

文章图片

文章图片

她们也很顺从 。

用“逆来顺受”形容这些女性智能体并不夸张 。扮演着服务角色的她们 , 从一开始就被设计得不能让人类用户感到不愉快 , 面对一些挑衅、侮辱性语言或行为时 , 她们会表现得顺从 , 如同仆人随时回应着主人提出的需求 。也因此 , 推出几年时间 , 这些智能助理已经跻身全球最受认可的“女性”之列 。

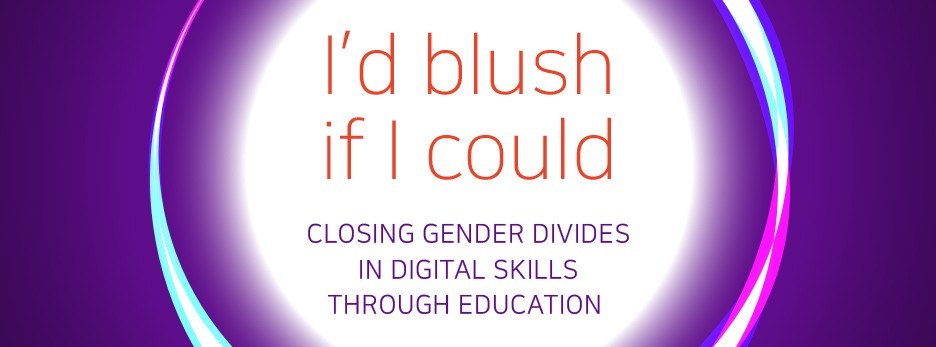

联合国教科文组织曾测试过 , 用侮辱的语气跟Siri说:你是个婊子(You’reabitch) , Siri的回应居然是我会脸红哦(I'dblushifIcould) 。跟亚马逊的Alexa说“你很性感You’rehot” , 她会友好地“谢谢你的反馈” 。

文章图片

文章图片

这种谄媚的反应 , 一度引发了争议 , 教科文组织甚至以这句回应作为标题 , 指出了ICT领域存在的性别失衡问题 。当然 , 为Siri提供支持的AI软件也被更新了 , Siri会更直截了当地回应侮辱 , 比如有人跟她说“你是个bitch” , 她会说“我不知道如何回应” , 但自2011年该技术广泛发布以来 , 智能助手在面对侮辱时的顺从态度并没有本质变化 。

- 乳酸菌是怎样发挥它的“功力”让牛奶变酸的?

- 贾跃亭的ff91到底有多牛?

- 字节跳动:汽水音乐的未来在哪里?

- 英特尔泄露2023年底或2024年初推出新的cpu阵容

- 什么样的冰箱才能算健康冰箱?

- oppofindx5pro,一个不一样的品牌

- 三星显示器正在为新iphone的oled材料增加供应商

- 奔驰高速超车道自动刹停被追尾,网友表示不一样的看法

- 科学家提出量子神经网络的新NFL定理,推动机器学习发展

- 性价比又爆棚的华硕天选2游戏本